sora模型国内可用吗?OpenAI近日展示了多个样本视频,展示了通过文本生成视频的可能性。分析人士指出,这是一个新兴的研究方向,也是2025年值得关注的趋势。OpenAI科学家Tim Brooks表示:“构建一套大模型,能够理解视频并捕捉世界中的复杂交互,是所有未来AI系统的重要里程碑。”下面,我们将探讨Sora模型在国内的可用情况。

sora模型国内使用解析:

自OpenAI发布GPT-4以来,业界一直期待GPT-5的出现,而Sora的发布引发了不小的轰动,其影响力不亚于一次重大模型升级。

作为OpenAI首推的文本转视频模型,Sora能根据文本指令或静态图像生成长达1分钟的视频内容。这些视频包含精细的场景细节、生动的角色表情以及复杂的镜头运动效果。Sora还支持对现有视频进行扩展或填补缺失帧,增强了其应用灵活性。

在视频生成长度上,Sora的60秒时长相比其他模型如Pika Labs的3秒、Emu Video的4秒和Runway Gen-2的18秒,展现出了显著优势。从官方演示来看,Sora的视频流畅度和细节表现力都令人印象深刻。

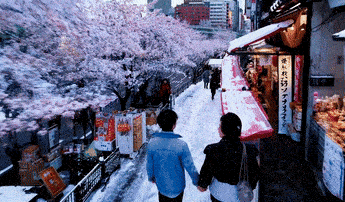

例如,官方推文展示了一段14秒的东京雪景视频。

提示词:Beautiful, snowy Tokyo city is bustling. The camera moves through the bustling city street, folowing several people enjoying the beautiful snowy weather and shopping at nearby stalls. Gorgeous sakura petals are flying through the wind along with snowflakes.

“美丽的,被雪覆盖的东京正繁忙着。镜头穿过繁忙的城市街道,跟随着几个享受雪景和在附近摊位购物的人。美丽的樱花瓣随风飘落,与雪花一同飞舞。”

Sora模型的核心技术基于大规模神经网络训练,通过深度学习理解文本语义并转化为动态视觉内容。这种能力在创意产业、教育视频制作和数字营销中具有广泛应用潜力。例如,设计师可以快速生成概念视频,教育者能创建互动教学材料,这为AI视频生成领域开辟了新路径。

在国内,AI技术发展迅速,许多平台正探索类似模型的集成。用户可通过官方渠道或合作伙伴平台尝试Sora相关功能。建议关注OpenAI的官方更新或国内AI社区资源,以获取最新使用信息。实际操作中,用户需提供清晰的文本指令,模型会输出高质量视频内容,但需注意遵守平台规则和版权要求。

从技术角度看,Sora的突破在于其多模态处理能力。它结合了自然语言处理和计算机视觉,确保视频中的物理规律如光影和运动保持真实。OpenAI强调,该模型旨在辅助人类创造力,而非替代,这为未来AI伦理应用提供了框架。

随着全球AI竞赛加剧,国内研究机构也在推进类似技术。Sora的引入可能加速本地化创新,用户可期待更多适应中文环境的工具出现。在尝试使用时,建议从简单提示开始,逐步探索复杂场景,以获得最佳体验。

以上内容为Sora模型国内可用性及使用方法的全面解析。如需进一步了解AI视频生成趋势,可持续关注相关资讯平台。